深入探讨LangSmith产品使用模式,揭示AI生态系统及人们构建LLM应用的方式如何演变。

作者:LangChain

阅读时间:6分钟

发布日期:2024年12月19日

又一年的LLM构建即将结束,而2024年同样不负期待。每月有近3万用户注册使用LangSmith,我们得以站在行业发展的第一线观察趋势。

如同去年一样,我们希望分享一些产品使用模式,展示AI生态系统及LLM应用构建实践的变化。随着用户在LangSmith中探索、评估和迭代,我们观察到一些显著的变化。这些变化包括开源模型采用率的迅速上升,以及从以检索为主的工作流向具有多步骤、智能体特征的AI智能体应用的转变。

请阅读以下数据,了解开发者正在构建、测试和优先处理的内容。

基础设施使用情况

随着大型语言模型(LLM)的普及,许多人在追问一个问题:“哪个模型的使用率最高?”让我们来看一下观察结果。

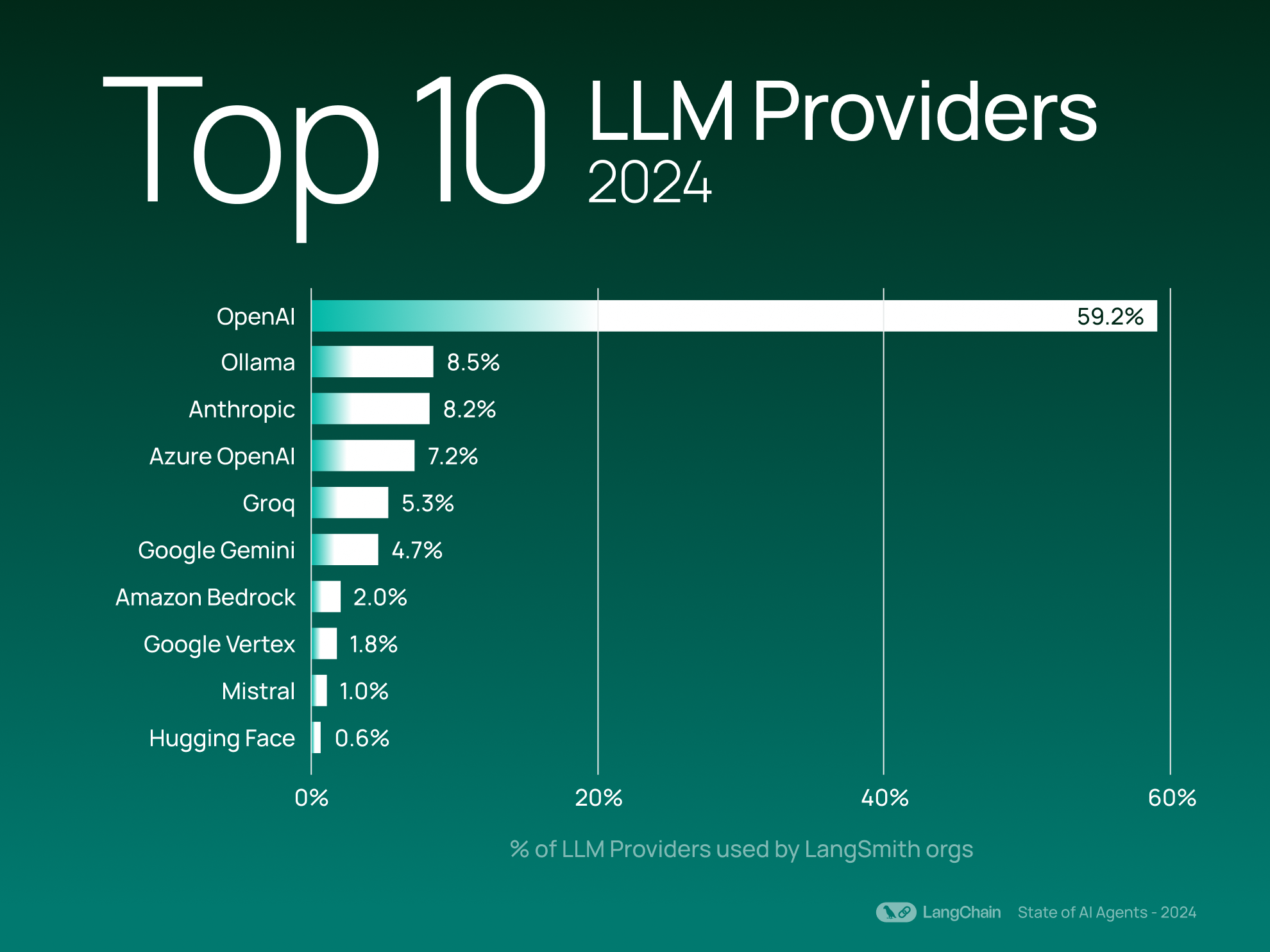

顶级LLM提供商

与去年的结果类似,OpenAI依然是LangSmith用户中最常使用的LLM提供商,其使用量超过第二名Ollama的6倍(按LangSmith组织使用量统计)。

值得注意的是,Ollama和Groq(均支持运行开源模型,前者专注于本地执行,后者专注于云端部署)今年加速发展,跻身前五名。这表明业界对更灵活的部署选项和可定制AI基础设施的兴趣日益浓厚。

在提供开源模型的服务商中,与去年相比,Ollama、Mistral和Hugging Face仍然是开发者使用开源模型的主要平台。这些开源服务商的整体使用量占前20大LLM提供商的20%(按组织使用量计算)。

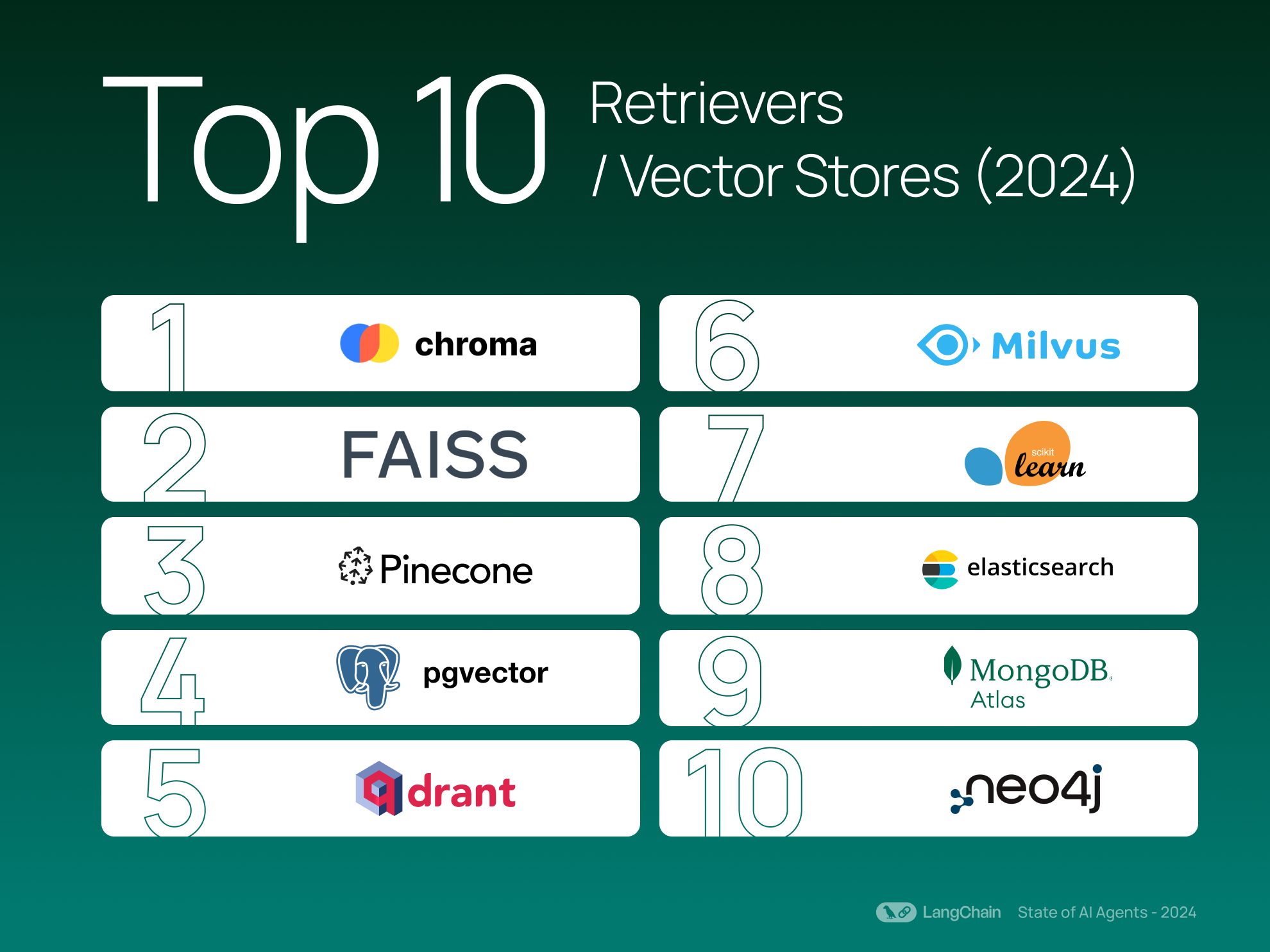

顶级检索器/向量存储

检索在许多生成式AI工作流中仍然至关重要。前3名向量存储与去年相同,Chroma和FAISS仍然是最受欢迎的选择。今年,Milvus、MongoDB和Elastic的向量数据库也进入前十。

使用LangChain产品的构建实践

随着开发者对生成式AI的使用经验不断增加,他们正在构建更具动态性的应用。从工作流的日益复杂,到AI智能体的兴起,我们看到了一些表明生态系统正在创新的趋势。

可观测性不仅限于LangChain应用

虽然LangChain(我们的开源框架)是许多用户开发LLM应用的核心,今年有15.7%的LangSmith追踪来自非LangChain框架。这反映了一种更广泛的趋势,即无论使用何种框架构建LLM应用,可观测性都是必要的,而LangSmith支持这种互操作性。

Python仍占主导地位,但JavaScript使用率上升

调试、测试和监控在Python开发者中备受欢迎,Python SDK的使用率为84.7%。但随着开发者追求以Web为主的应用,对JavaScript的兴趣显著增长——JavaScript SDK今年的使用率为15.3%,同比增长3倍。

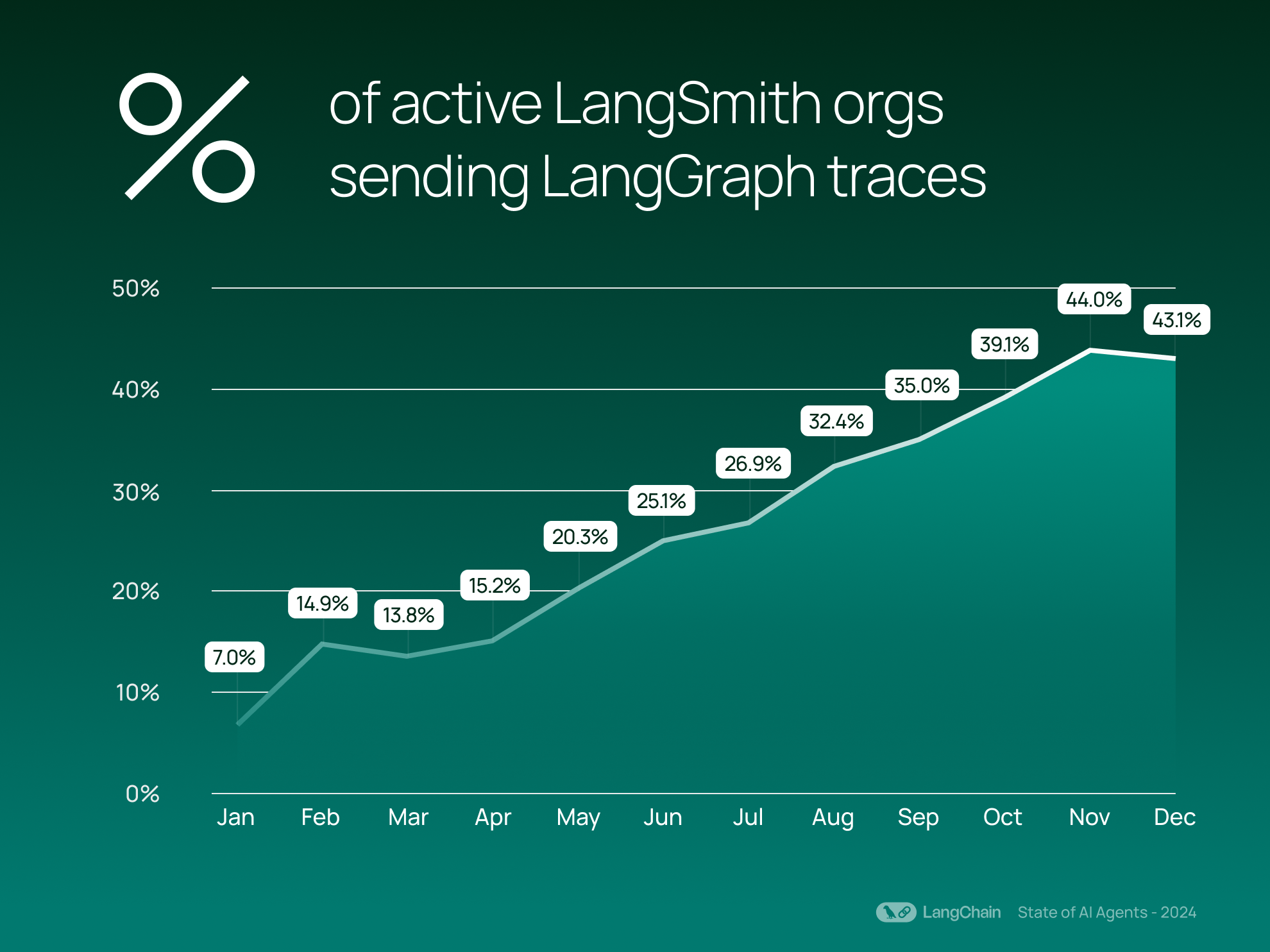

AI智能体正在崭露头角 (AI agents)

随着企业在各行业中更加认真地引入AI智能体,我们的可控智能体框架LangGraph的采用率也在上升。自2024年3月发布以来,LangGraph稳步获得关注,目前已有43%的LangSmith组织发送LangGraph追踪。这些追踪代表超越基本LLM交互的复杂、协调任务。

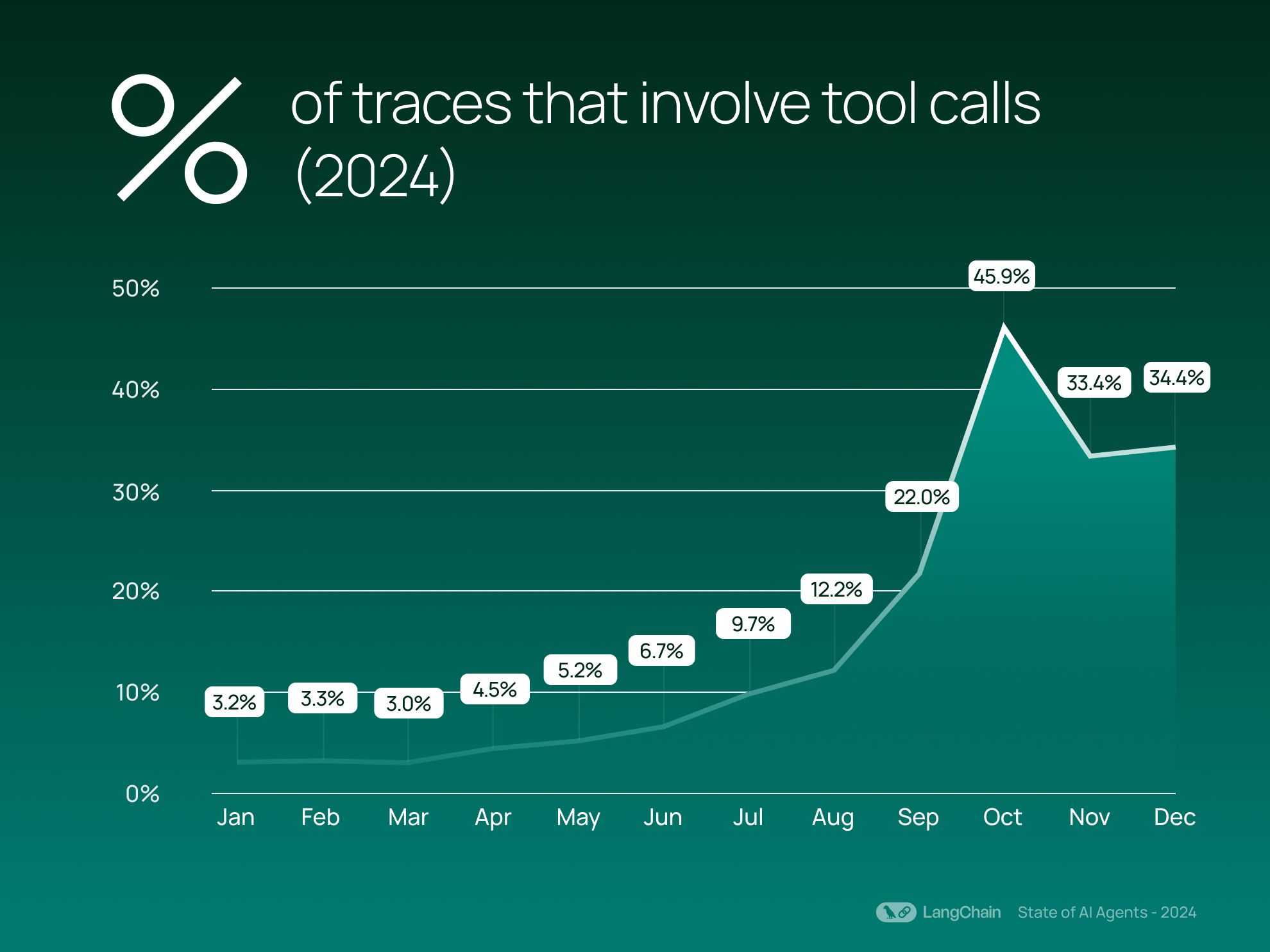

这一增长与智能体行为的兴起一致:平均有21.9%的追踪现在涉及工具调用,而2023年平均仅为0.5%。工具调用允许模型自主调用功能或外部资源,表明模型在决定何时采取行动方面表现出更多智能体行为。工具调用的增加可以增强智能体与外部系统交互的能力,执行诸如写入数据库之类的任务。

性能与优化

在开发应用(尤其是利用LLM资源的应用)时,平衡速度与复杂性是一项关键挑战。以下是组织如何与其应用交互以使需求的复杂性与高效性能相匹配的探索。

复杂性增长,但任务处理效率提高

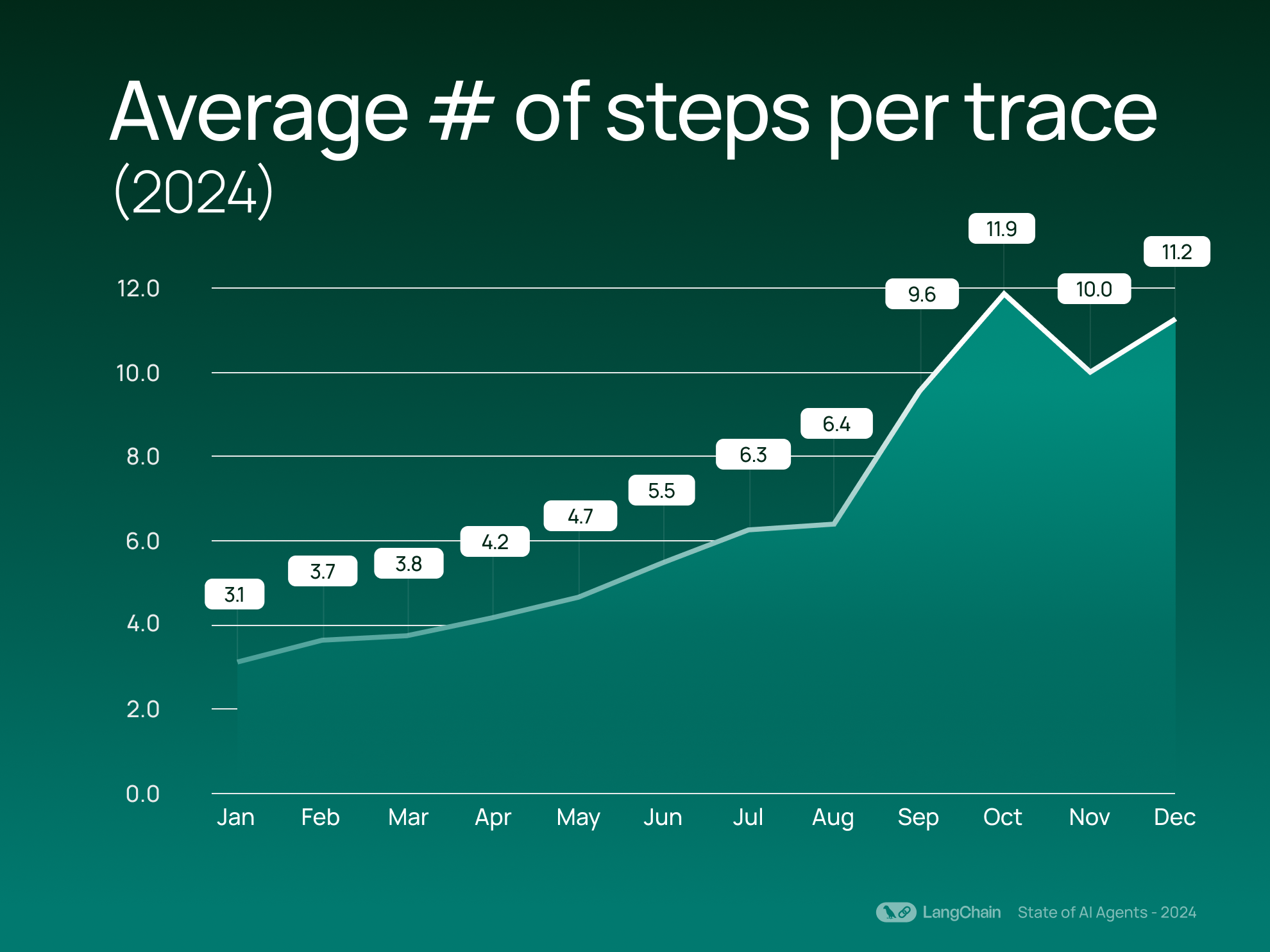

每次追踪的平均步骤数量在过去一年中翻倍,从2023年的2.8步增加到2024年的7.7步。我们将步骤定义为追踪中的独立操作,例如调用LLM、检索器或工具。这一增长表明组织正在利用更复杂和多方面的工作流。与简单的问答交互不同,用户正在构建将多个任务(如信息检索、处理和生成可操作结果)串联在一起的系统。

相比之下,每次追踪的LLM调用平均数量仅小幅增长,从1.1增加到1.4。这表明开发者正在设计系统,通过减少LLM调用实现更多功能,在保持功能的同时控制昂贵的LLM请求。

LLM测试与评估

组织如何测试其LLM应用以防止不准确或低质量的LLM生成响应?尽管保持LLM应用的高质量并非易事,但我们观察到组织使用LangSmith的评估功能,自动化测试并生成用户反馈循环,以创建更强大、更可靠的应用。

LLM评审:评估重点

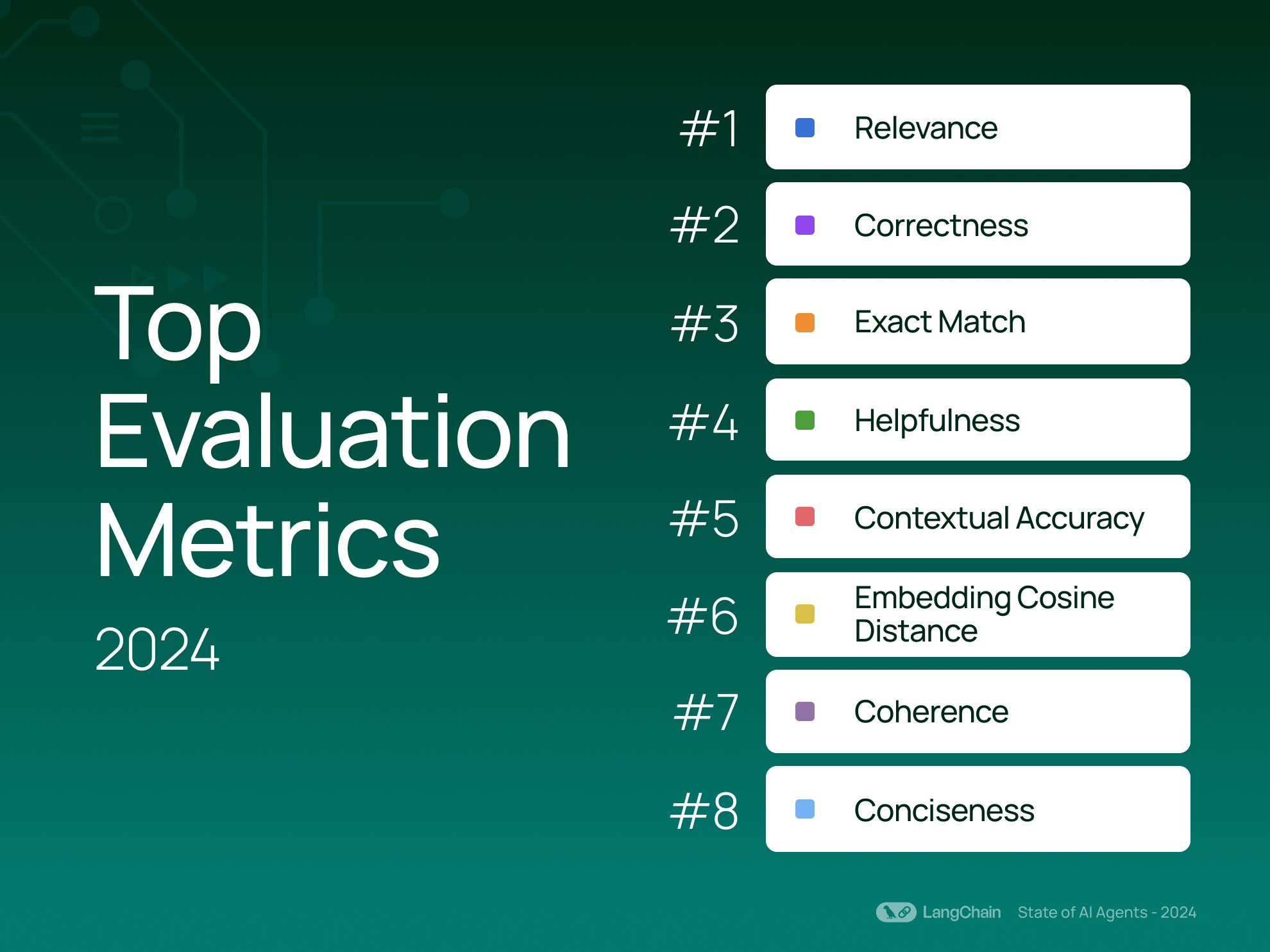

LLM评审器通过将评分规则嵌入LLM提示中,并使用LLM根据特定标准对输出进行评分。我们看到开发者最常测试以下特性:相关性、正确性、精确匹配和有用性。

这些测试表明,大多数开发者正在进行粗略检查,以确保AI生成的输出不会完全偏离目标。

借助人工反馈迭代

人工反馈是LLM应用迭代循环的关键部分。LangSmith加快了收集和整合追踪与运行(即跨度)上的人工反馈的过程,使用户能够创建丰富的数据集以进行改进和优化。过去一年中,带注释的运行数量增长了18倍,与LangSmith使用量的增长呈线性关系。

每次运行的反馈量也略有增加,从2.28条增加到2.59条。然而,每次运行的反馈仍然相对稀疏。用户可能优先考虑速度,而非全面评论,或仅对最关键或存在问题的运行进行反馈。

结论

2024年,开发者通过多步骤智能体拥抱复杂性,通过减少LLM调用提升效率,并通过反馈和评估方法为应用添加质量检查。随着更多LLM应用的创建,我们期待看到用户深入挖掘更智能的工作流、更优异的性能以及更高的可靠性。

了解更多关于LangSmith如何为您的LLM应用开发带来更多可见性并提升性能——从调试瓶颈到评估响应质量,再到监控回归的方法。