重新定义智能问答系统的实现方式

引言

智能客服系统已经成为现代企业不可或缺的服务工具。当用户提出问题时,系统需要从海量文档中快速找到相关内容并给出准确回答。传统上,我们通过RAG(Retrieval-Augmented Generation,检索增强生成)技术来实现这类系统,而RAG通常依赖于向量化技术进行内容匹配。

然而,OpenAI最近分享了一个令人耳目一新的RAG实现方案——整个过程完全不涉及向量化操作。这种创新方法不仅简化了技术架构,还在某些场景下展现出更优的性能表现。

RAG技术基础回顾

在深入了解OpenAI的新方案之前,让我们先理解传统RAG技术的工作原理。

想象您要构建一个智能客服系统,用户可以询问公司产品的相关信息。仅有大语言模型是不够的,因为模型并不了解您公司的具体产品信息。如果直接询问,模型只能回答"不知道"。

虽然可以将完整的产品手册提供给模型,但这种方法存在诸多问题:产品手册通常非常冗长,模型可能读了后面忘了前面;处理如此长的内容成本高昂,耗时也很长。

RAG技术正是为解决这个问题而生。它能够从文档中精确抽取与用户问题相关的内容。例如,从一千页的产品手册中找出与用户问题相关的三段话,然后将这些相关内容与用户问题一起发送给模型。这样,模型就能基于相关信息准确回答用户问题。

传统RAG方案通过向量化技术完成内容匹配——将文字转换为数字列表进行相似度计算和匹配。

OpenAI无向量化RAG方案架构

OpenAI提出的这个方案专门用于构建法律知识问答系统,整个流程包含五个核心环节:

1. 文件加载(Document Loading)

系统首先读取约1000页的法律PDF文件,提取其中的文本内容并转换为字符串格式供后续处理。

2. 内容切割(Content Chunking)

将提取的文档内容切割成多个部分。与演示中的3份不同,实际实现中会切割为20份,这个数量更适合实际应用需求。

3. 内容挑选(Content Selection)

这是整个方案的核心创新点。系统会将切割后的内容发送给大语言模型,让模型判断哪些部分与用户问题相关。

4. 多轮迭代优化

内容切割和挑选过程会重复多次(通常3次)。每一轮都会对上一轮选中的内容进行进一步细分和筛选,逐步缩小范围直到找到最相关的内容片段。

5. 答案生成(Answer Generation)

将最终筛选出的相关内容与用户问题一起发送给大语言模型,生成初步答案。

6. 答案验证(Answer Verification)

使用另一个模型验证生成的答案是否基于引用内容回答,是否存在胡编乱造的情况。只有通过验证的答案才会返回给用户。

技术实现细节

模型选择策略

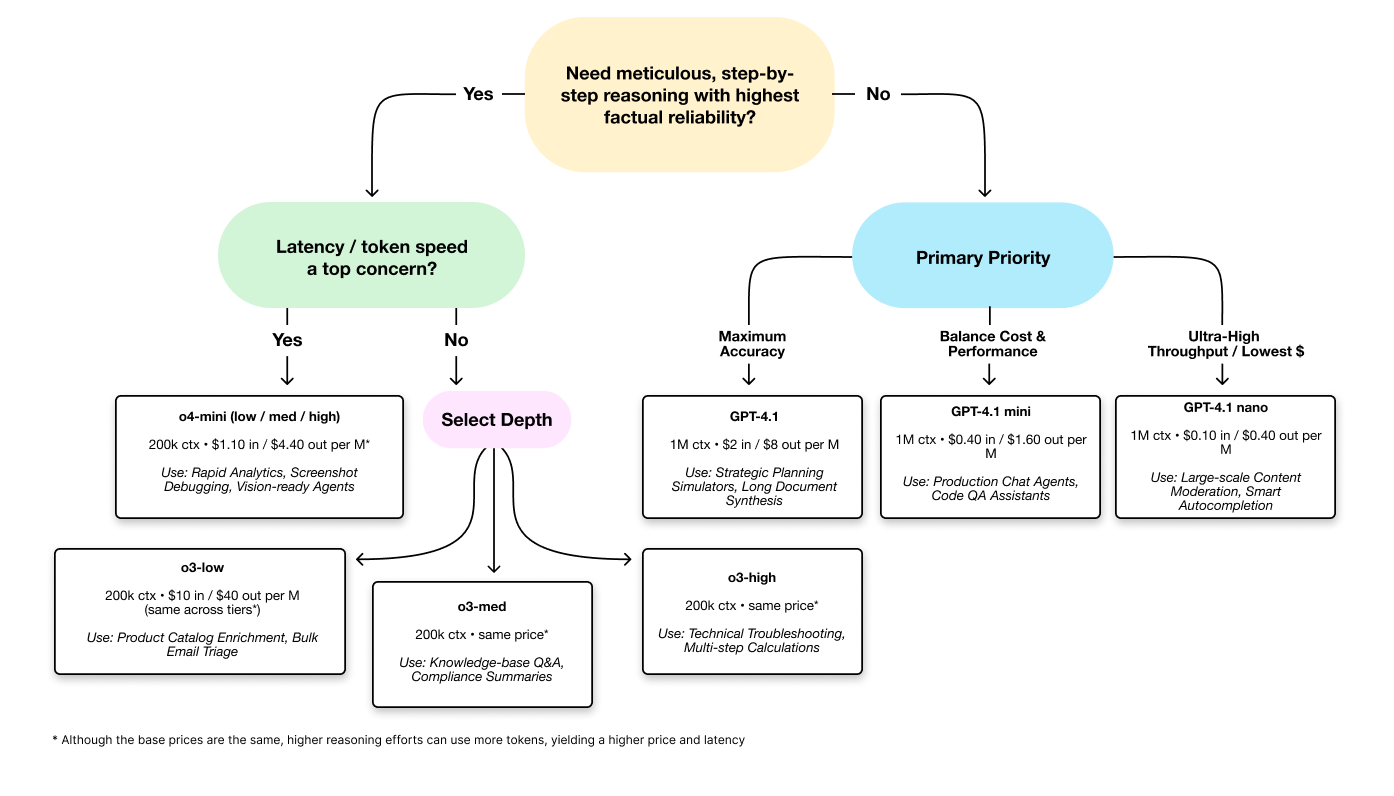

不同环节使用不同的模型,体现了精细化的成本控制和性能优化:

内容挑选环节使用GPT-4.1 Mini,主要考虑两个因素:首先,GPT-4.1 Mini拥有100万token的超大上下文窗口,能够处理大量文本输入;其次,该模型价格相对低廉,适合处理大量文本输入的成本控制需求。

答案生成环节采用GPT-4.1,因为这个环节需要保证答案的准确性。虽然成本稍高,但此时模型输入已经经过筛选,输入量大幅减少,成本可控。

答案验证环节使用O1模型,该模型推理能力强,非常适合对答案准确性进行判断。

迭代式内容筛选的优势

为什么要进行多轮切割和挑选,而不是一次性将文档切成几百份让模型直接选择呢?

多轮迭代的方法效果更好,原因在于:一次性切割过于细碎的内容会让模型难以理解上下文关系,容易产生混乱;而逐步细化的方法让模型能够更好地理解内容层次和关联性,提高选择的准确性。

代码实现框架

整个系统的代码结构清晰,主要包含以下核心函数:

load_document(): 负责PDF文档加载和文本提取split_into_chunks(): 实现内容切割功能route_chunks(): 处理内容挑选逻辑navigate_to_paragraph(): 管理多轮切割和挑选的迭代过程generate_answer(): 生成初步答案verify_answer(): 验证答案准确性

法律文档分析平台

方案优势与局限性

优势分析

无需预处理:不需要提前对文档进行向量化处理,文档修改后可以立即生效,部署和维护更加便捷。

模拟人类阅读:整个过程模拟了人类阅读和理解文档的方式,理论上准确率更高。

查询范围更广:相比传统RAG模式通常局限于文档中的某一小部分,这种方法能够查询更广泛的内容。

更好的上下文理解:通过多轮迭代,能够更好地理解内容的层次结构和关联关系。

局限性分析

成本较高:每次查询需要多次调用大语言模型,单次查询成本约0.36美元,相比传统方法成本更高。

查询时间长:多轮迭代和验证过程导致查询响应时间较长。

文档规模限制:受限于模型上下文窗口大小,无法处理过大的文档。当前方案适用于约100万token以内的文档。

模型依赖性强:整个方案高度依赖大语言模型的理解和判断能力,模型性能直接影响系统效果。

推理,并具有最高的

事实可靠性?

是首要关注点?

(各层级价格相同*)

实际应用考虑

适用场景

这种无向量化RAG方案特别适合以下场景:

文档内容经常更新,需要快速响应变化的业务环境

对答案准确性要求极高的专业领域,如法律、医疗等

文档内容复杂,需要深度理解上下文关系的应用

不希望维护复杂向量数据库的轻量级部署

优化建议

成本优化:考虑使用开源模型替代商业API,虽然前期投入较高,但长期运营成本更低。

性能优化:可以通过并行处理、缓存机制等技术手段优化查询速度。

内容筛选优化:在最终选择阶段,可以让模型再次精选最相关的内容,而不是简单地选择前几个结果。

技术发展趋势

OpenAI的这个方案代表了Agent RAG的发展方向,即让大语言模型更多地参与到检索和筛选过程中,而不仅仅是最后的生成环节。这种方法体现了以下技术趋势:

从工程优化到智能优化:相比传统的向量相似度计算,使用大语言模型进行内容理解和匹配更加智能化。

模型协作模式:不同能力的模型承担不同任务,实现成本和性能的最优平衡。

端到端的AI化:整个流程更多地依靠AI的理解能力,减少人工规则和预处理步骤。

结论

OpenAI的无向量化RAG方案为我们提供了一种全新的智能问答系统实现思路。虽然在成本和速度方面存在一定局限性,但其在准确性、灵活性和易维护性方面的优势不容忽视。

随着大语言模型性能的不断提升和成本的持续下降,这种方法有望在更多场景中得到应用。对于需要高精度问答、文档频繁更新或者希望简化技术架构的应用场景,这种无向量化RAG方案值得深入研究和尝试。

技术的发展从来不是线性的,OpenAI的这个方案提醒我们,有时候跳出传统思维框架,用更直接、更智能的方法解决问题,可能会带来意想不到的效果。在AI快速发展的今天,保持开放心态,积极探索新的技术路径,将是我们在技术浪潮中保持领先的关键。